Il tema delle intelligenze artificiali è molto vivo e dibattuto e abbraccia ad oggi una grossa fetta degli ambiti di ricerca e innovazione, dall’automotive, alla fotografia fino alla traduzione e molti altri ancora. Si è già detto che ormai le intelligenze artificiali lavorano a pieno ritmo e che hanno raggiunto livelli impressionanti in un tempo relativamente breve. Tuttavia la recente notizia dell’incidente mortale provocato da un veicolo con cui Uber stava testanto la guida autonoma, porta a rivalutare alcuni dei recenti successi della ricerca nel campo delle intelligenze artificiali.

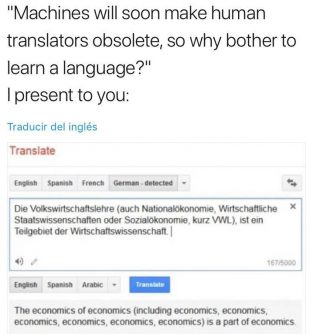

Viene spontaneo chiedersi quanto davvero si possa fare affidamento su un sistema ancora così vulnerabile. Nel caso delle traduzione gli esempi sono svariati, dalla traduzione incorretta di testi non in prosa, fino a traduzioni completamente errate. Talvolta di fronte ad espressioni colloquiali o a una negazione messa nel posto grammaticalmente sbagliato (ma magari linguisiticamente corretto), la macchina fatica a interpretare correttamente il segmento che le si sottopone dando come output una traduzione “brutta”, concettualmente errata o addirittura una ripetizione dell’ultima parola che è riuscita a capire. Inoltre quando le si pongono sfumature di significato o, come nel caso del tedesco, parole composte con significati simili, l’output è disastroso. Ne è un esempio l’immagine buffa, quanto realistica che gira in rete da qualche tempo:

Per la traduzione il problema è molto relativo, perché esistono (per fortuna) i post-editor che evitano che una traduzione di questo genere possa circolare e soprattutto correggono gli errori potenzialmete pericolosi che la macchina potrebbe commettere.

Il problema reale si pone di fronte a tecnologie che puntano a sostituire la presenza umana senza un controllo tra l’output della macchina e l’impatto sulla vita reale, come nel caso della guida autonoma. Che l’intelligenza artificiale possa impazzire è molto preoccupante, ma soprattutto indica che queste intelligenze artificiali non sono ancora realmente autonome, ma che devono essere tenute troppo per mano dall’elemento umano.

Inoltre il problema ancora maggiore si pone sul fronte della sicurezza: infatti, per poter progredire, le intelligenze artificiali hanno bisogno di poter esplorare il mondo digitale, esponendosi così al rischio di attacchi informatici che ne modificano l’apprendimento, un esempio lampante è illustrato nell’articolo apparso su Motherboard in cui si parla di un attacco sperimentale che ha fatto molto discutere la comunità scientifica:

[…] solo tre giorni dopo l’annuncio uno studente del primo anno del MIT, Anish Athalye, ha lanciato una pagina web in cui dimostra di aver forzato e penetrato sette tra i nuovi modelli di difesa presentati dai paper selezionati, anche da istituzioni di altissimo profilo come Google, Amazon e Stanford.

“Un programmatore malintenzionato con un po’ di creatività può creare facilmente un attacco per aggirare tutte queste difese” ha scritto Athalye. Questo giovane studente del MIT ha lavorato al progetto con Nicholas Carlini e David Wagner, rispettivamente uno studente e un professore a Berkeley. La pubblicazione del progetto ha portato a un piccolo vespaio tra accademici su alcuni dettagli delle loro affermazioni. Ma la cosa che sembra interessante è che esiste al momento una piccola disputa su uno dei messaggi che ne derivano: non è chiaro come trovare un modo sicuro per proteggere le deep-neural-network continuando contemporaneamente a incrementare le innovazioni guidate dalle AI.